Liên hệ quảng cáo

Kỹ sư phần mềm cho rằng tai nạn của Tesla đang bị thổi phồng

Một tháng trước khi gặp tai nạn chết người, Joshua Brown đã từng ca ngợi Autopilot khi tính năng này tránh cho ông va chạm với một chiếc xe màu... trắng.

|

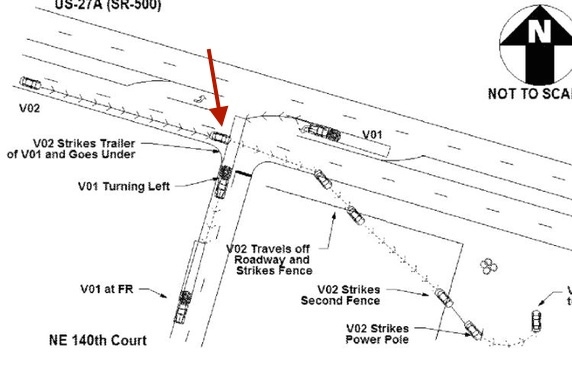

| Sơ đồ tai nạn chết người của Tesla Model S. |

Chúng ta mới chỉ đi qua 6 tháng đầu năm 2016, song có lẽ sự kiện quan trọng nhất của thế giới công nghệ năm nay gần như chắc chắn thuộc về Tesla. Đó sẽ không phải là một niềm vinh hạnh cho Elon Musk, bởi sự kiện mà tôi nhắc tới ở đây là vụ tai nạn chết người do chiếc Model S chạy ở chế độ tự lái (Autopilot) gây ra.

Những nét chính của sự việc là như sau: ngày 7/5 vừa qua, Joshua D. Brown, nhà sáng lập của một công ty công nghệ và cũng là một tín đồ Tesla đã thiệt mạng khi chiếc Model S của ông va chạm với một chiếc xe kéo đang qua đường. Trước khi tai nạn này xảy ra, ông Brown đã từng quay nhiều đoạn video về khả năng tự lái của chiếc Model S và cũng từng bị phạt tới 6 lần vì tội phóng nhanh.

Bạn có thể nhìn vào bức hình phía trên để hình dung về tai nạn, trong đó V01 là chiếc Model S xấu số còn V02 là chiếc xe kéo. Khi Model S rẽ trái, hệ thống tự lái Autopilot đã không thể phân biệt được màu trắng của phần rơ-moóc phía sau xe kéo và tiếp tục đi thẳng. Tài xế Brown được cho là đang để Model S tự điều khiển và xem phim Harry Potter thay vì đặt tay trên vô lăng để kiểm soát như khuyến cáo của Tesla. Kết quả là Model S lao vào gầm rơ moóc, túi khí không bật và ông Brown thiệt mạng.

Rõ ràng là vụ việc này có rất nhiều dữ kiện đòi hỏi phải nhìn nhận một cách tổng thể. Tuy vậy, thoạt nhìn, tất cả những gì tôi, bạn và rất nhiều người khác cần quan tâm nhất vẫn là “Liệu xe tự lái có đủ an toàn để trở thành tương lai của giao thông đường bộ?”. Tiếp đến, trong vụ tai nạn của ông Brown, Tesla có phần sai hay không?

Câu trả lời là “Có” và “Có”.

Giấc mơ xe tự lái

Một tháng trước khi gặp tai nạn chết người, Joshua Brown đã từng ca ngợi Autopilot khi tính năng này tránh cho ông va chạm với một chiếc xe màu... trắng.

Đầu tiên, hãy cùng bàn về mức độ an toàn của xe tự lái. Con người đã mơ về xe tự lái từ rất lâu, và ngay cả những bộ phim khoa học viễn tưởng quen thuộc với 8X và 9X như Wall-E, Minority Report và I, Robot cũng coi xe tự lái là tương lai. Trong những bộ phim này, bạn có thể thấy những chiếc xe tự lái dàn hàng đều tăm tắp đi trên đường ở tốc độ rất cao. Không chỉ giảm thời gian cho hành khách, chúng còn ổn định và cực kỳ an toàn (ít nhất là cho tới khi nhân vật chính xuất hiện).

“An toàn” là từ khóa quan trọng nhất ở đây. Ấy vậy mà hệ thống xe tự lái của Tesla đã gây ra một tai nạn chết người. Ngay cả thông cáo của Tesla rằng Autopilot chạy 130 triệu dặm mới gặp tai nạn chết người đầu tiên trong khi tỷ lệ thông thường trên toàn cầu là 60 triệu dặm và tại nước Mỹ là 94 dặm cũng không thể làm yên lòng người dùng.

Nhưng với một kỹ sư phần mềm như tôi, tai nạn chết người đầu tiên của Tesla Autopilot là không có gì bất ngờ và cũng không có gì đáng phải lo lắng hay thổi phồng. Thực tế, đây gần như là một sự kiện tất yếu sẽ xảy ra.

|

|

Fukushima nằm trong một danh sách rất dài: các thảm họa xảy ra khi các kỹ sư không dự tính hết các trường hợp có thể xảy ra với hệ thống. |

Lý do là bởi trong ngành phần mềm nói riêng và toàn bộ các ngành kỹ thuật/kỹ nghệ nói chung, các kỹ sư đều hiểu rằng việc tạo ra một hệ thống phần cứng + phần mềm không có lỗi là chuyện không thể. Các coder kỳ cựu hiểu rằng dù họ có tự tin đến mấy thì sản phẩm của họ vẫn phải qua bàn tay của tester (kiểm thử), và ngay cả những hãng phần cứng hàng đầu thế giới như Apple, Samsung hay Toyota cũng đã vô số lần để xảy ra lỗi trên sản phẩm đến tay người dùng.

Cần phải chỉ ra rằng hậu quả khi anten iPhone bị đặt ở vị trí ngớ ngẩn sẽ tai hại hơn rất nhiều so với khi hệ thống xe tự lái bị lỗi. Nhưng ngay đến cả các chương trình vũ trụ của NASA và Roscomos cũng đã vô số lần gặp lỗi, khiến hàng chục con người ưu tú của cả loài người thiệt mạng và hàng tỷ USD tan biến vào mây khói. Thảm họa hạt nhân Fukushima xảy ra là vì các kỹ sư không tính tới khả năng nước tràn vào nhà máy gây tê liệt hệ thống.

Nói cách khác, bất kể hệ thống của bạn quan trọng tới đâu, khả năng tạo ra một hệ thống hoàn toàn không có lỗi là không thể. Những người kém hiểu biết về công nghệ có thể “bù lu bù loa” về vụ tai nạn chết người của Model S, nhưng tôi tin chắc rằng bất cứ một kỹ sư phần cứng, phần mềm hay một ngành nghề nào khác đều sẽ hiểu rằng sự cố này là không tránh khỏi.

Cái sai của Tesla: Cái ngông của Elon

Nói như vậy không có nghĩa rằng các kỹ sư như tôi sẽ khoanh tay đứng nhìn hệ thống của mình đi vào hoạt động ở trạng thái đầy lỗi rồi phủi tay “Không thể tránh được”. Một hệ thống không có lỗi là hoàn toàn không tưởng, nhưng ngành công nghệ nói riêng và các ngành kỹ thuật khác luôn cần phải tìm cách giảm thiểu đến hết mức có thể những lỗi xảy ra. Chìa khóa để làm được điều này là lĩnh vực kiểm thử (testing).

|

|

Chiếc Model S của ông Joshua Brown tan nát sau khi gặp tai nạn. |

Bản chất của testing là gì? Trong testing, việc kỹ sư cần làm luôn là nghĩ ra tất cả các kịch bản có thể xảy đến, thực hiện các kịch bản đó để đảm bảo hệ thống của họ sẽ phản ứng/hoạt động theo cách mong muốn.

Trong rất nhiều trường hợp, các “thảm họa” lỗi xảy ra khi kỹ sư không nghĩ ra kịch bản có thể khiến hệ thống của họ gặp lỗi. Ví dụ, khi chế tác iPhone 4, Steve Jobs và cộng sự đã không nghĩ ra rằng người dùng có thể chèn tay lên vị trí đặt camera khiến cho iPhone mất sóng. Với iPhone 6 Plus, Apple không đự đoán được rằng một chiếc smartphone mỏng và to bản rất có thể bị bẻ cong trong quá trình sử dụng.

Model S thì sao? Các báo cáo cho biết hệ thống tự lái trên Model S đã không thể phân biệt được màu trắng của bầu trời và màu trắng trên rơ-moóc của chiếc xe kéo đang rẽ trái trước mặt. Xe tiếp tục đi thay vì phanh khẩn cấp và tai nạn xảy ra.

Hoặc Tesla đã có thể nghĩ tới kịch bản đó, nhưng camera trên xe không đủ tốt để phân biệt, hoặc kể cả camera thu được hình ảnh tốt thì thuật toán của Autopilot đã không thể phân biệt được màu trắng của bầu trời nắng và màu trắng của xe.

Elon Musk bảo vệ Autopilot một cách cực kỳ quyết liệt khi tuyên bố các bài viết tiêu cực của tạp chí Fortune là do bên thứ ba tài trợ.

Bạn đừng vội nghĩ lỗi thuộc về các kỹ sư kiểm thử của Tesla. Trái lại, từ quan điểm của một người làm trong ngành engineering, tôi cho rằng tình huống xảy ra tai nạn là cực kỳ hy hữu. Những lỗi hy hữu như vậy khó có thể được phát hiện trong nhà máy hay trong trường đua mà thường sẽ được phát hiện khi đưa hệ thống vào hoạt động thực tế ở chế độ kiểm thử. Đây chính là chế độ mà Google đã áp dụng cho chương trình xe tự lái của hãng trong vòng 2 năm vừa qua.

Tất cả các hãng khác như Volvo, Mercedes hay Audi cũng mới dám cho xe của họ tham gia giao thông ở quy mô nhỏ với mục đích duy nhất là kiểm thử. Đáng tiếc rằng Tesla đã đốt cháy giai đoạn kiểm thử thực tế ở quy mô nhỏ. Vào tháng 10 năm ngoái, Tesla phát hành bản cập nhật cho phép bất kỳ chiếc xe nào của họ cũng có thể lái tự động một cách dễ dàng. Tổng số xe Tesla có mặt trên thị trường vào thời điểm này là vài trăm nghìn chiếc.

Nói cách khác, thay vì tiếp tục thực hiện các chương trình thử nghiệm cỡ nhỏ, chỉ bằng một bản cập nhật đơn giản Tesla đã biến hàng trăm nghìn người thành nguồn cung cấp dữ liệu test khổng lồ. Dĩ nhiên, công ty của Elon Musk cũng đã khôn khéo trốn tránh khỏi các ràng buộc pháp lý bằng văn bản thỏa thuận EULA có quy định rõ người lái bắt buộc phải nắm vô-lăng khi Autopilot đang hoạt động.

Nhưng con người là con người. Chúng ta sẵn sàng lái xe khi đã say xỉn. Khi Autopilot được phát hành rộng rãi, dù vẫn là ở giai đoạn thử nghiệm với các điều khoản kiểm soát chặt chẽ từ Tesla, chẳng có gì khó hiểu khi con người sẵn sàng ngủ trong xe hoặc xem DVD và để kệ cho hệ thống cảm biến/máy tính tự xoay xở.

Vậy tai nạn chết người có tránh được không?

Đừng mất lòng tin

Bất chấp tất cả những điều này, giao thông tương lai vẫn phụ thuộc vào xe tự lái. Hãy nhớ rằng máy móc (và thuật toán, AI...) hoạt động cực kỳ ổn định, miễn là người kỹ sư dự đoán được và “dạy” được cho chúng tất cả các kịch bản có thể xảy ra. Đứng từ góc nhìn này, ngay cả vụ tai nạn của ông Brown cũng sẽ là một bước tiến cho lĩnh vực xe tự lái: từ nay trở đi, hãng xe tự lái nào cũng sẽ phải đặc biệt chú ý đến vấn đề phân biệt giữa màu của bầu trời và màu trắng trên những chiếc xe ngược chiều.

Xe tự lái sẽ trưởng thành hơn qua mỗi vụ tai nạn – theo cùng một cách ngành hàng không trở nên an toàn hơn sau mỗi thảm họa.

Chính góc nhìn này cũng là lý do vì sao bạn cần phải tin vào tương lai của xe tự lái thay vì phí thời gian đọc những con số được Tesla đưa ra để “chữa cháy”. Tất cả các tình huống giao thông, kể cả ở những đất nước như Việt Nam, đều có thể được tổng hợp lại thành một bộ cơ sở dữ liệu để làm bài học cho máy móc. Nếu bạn hiểu về Big Data, bạn sẽ thấy số lượng đường đi, ổ gà, vật thể có thể xuất hiện, kiểu lái của các phương tiện khác... tuy nhiều nhưng không phải là vô hạn, và thực tế chỉ cần thống kê được 99% số đó là chúng ta đã có thể tạo ra những chiếc xe tự lái an toàn gần như tuyệt đối.

Sau vụ tai nạn kể trên, khả năng xe tự lái lao vào xe tải có màu trắng vì nhầm lẫn với màu trời đã bị giảm đi đáng kể. Còn con người thì sao? Hàng triệu năm tiến hóa rồi mà chúng ta vẫn sẵn sàng vừa lái xe vừa nhắn tin.

Vậy tương lai nên thuộc về xe tự lái hay thuộc về người lái? Tôi nghĩ câu trả lời là rất rõ ràng.

Tag:

Bình luận

Thông báo

Bạn đã gửi thành công.